.avif)

Les nouveautés de décembre 2025

Découvrez les nombreuses nouveautés de fin d'année qui viennent enrichir la plateforme d'évaluation des connaissances et de formation Experquiz !

Listes de résultats

Le nouveau design

Les listes de résultats sont nombreuses et permettent à la fois de visualiser rapidement les résultats et d’accéder directement aux actions de gestion des activités, telles que l’ajout de participants, l’export des données ou la correction …

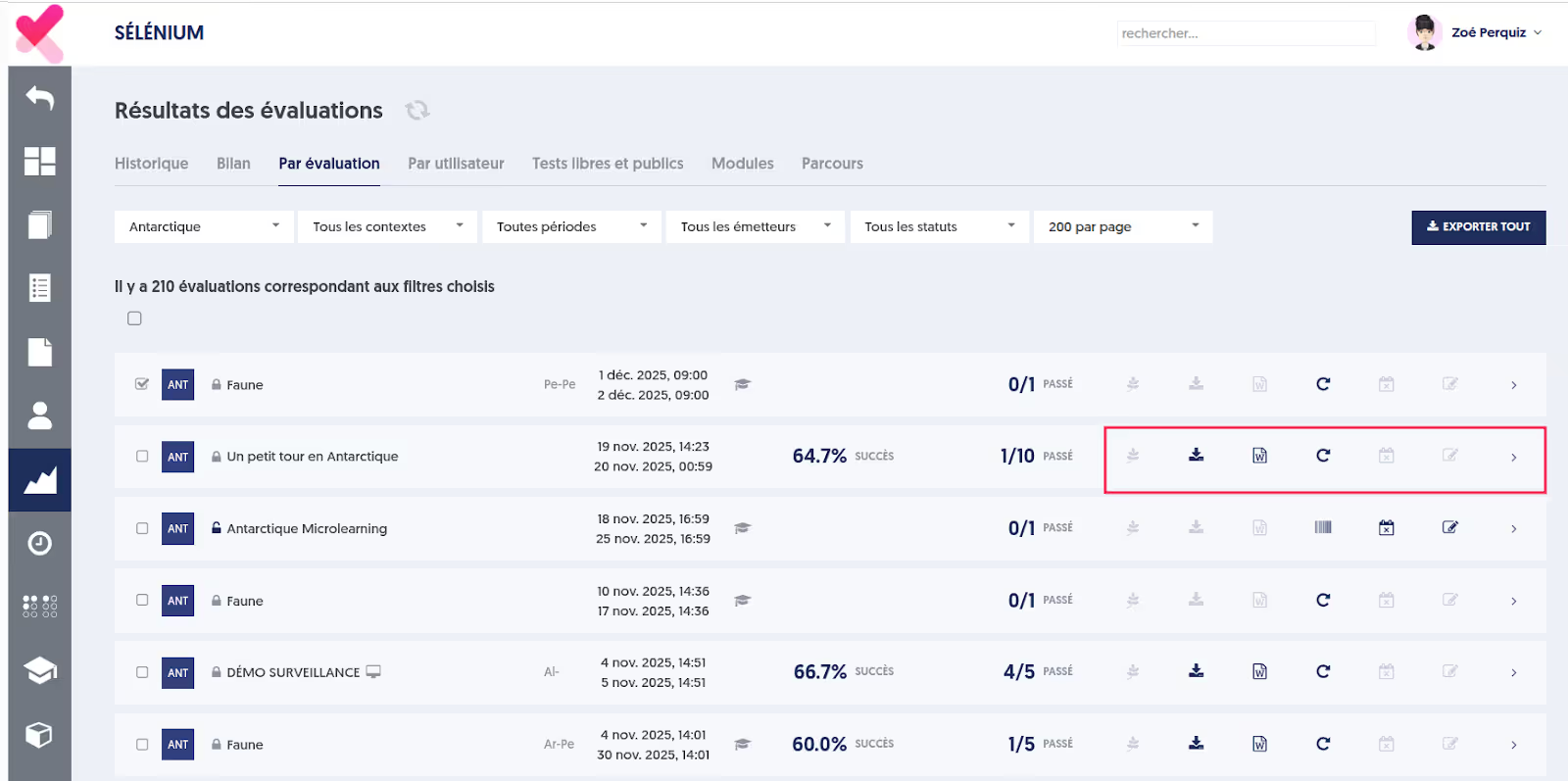

Une refonte a été réalisée afin de mieux séparer la visualisation des résultats des actions de gestion. Les actions de gestion, qui étaient auparavant présentées sous forme de boutons alignés sur chaque ligne, et qui pouvaient parfois disparaître sur les petits écrans, sont désormais regroupées sous un bouton unique, portant un pictogramme “hamburger”.

Ainsi la table des résultats des évaluations suivante :

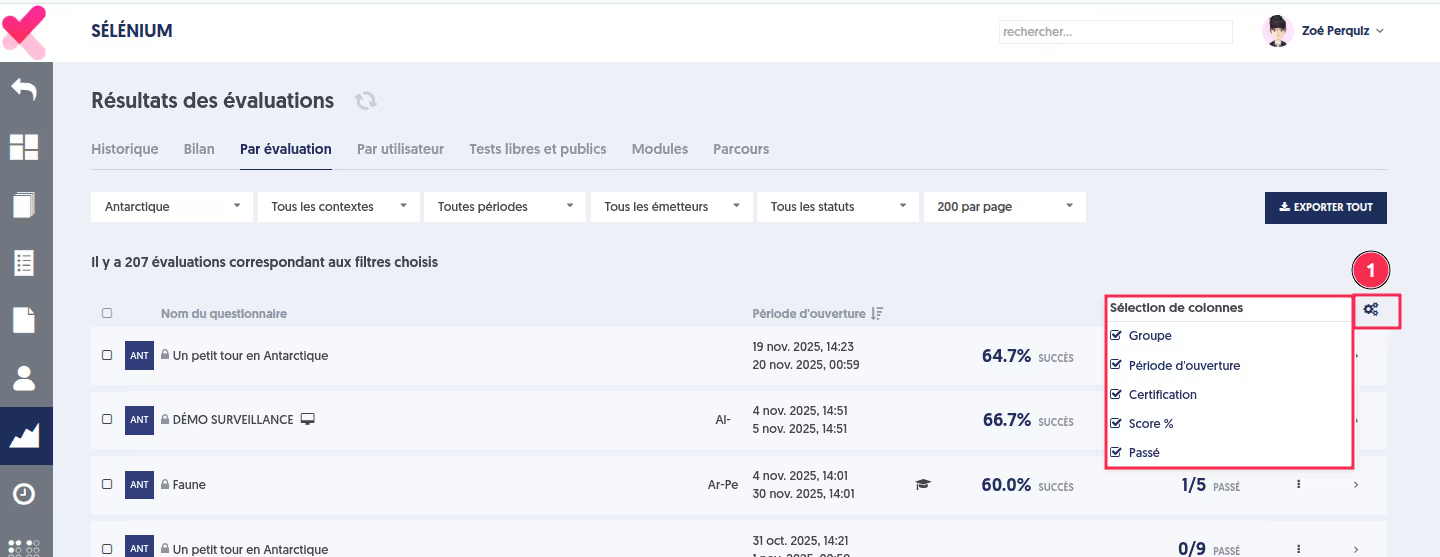

Deviendra :

Une autre amélioration concerne la possibilité de choisir les colonnes affichées. En cliquant sur la roue dentelée, vous pouvez personnaliser votre liste en cochant les colonnes que vous souhaitez voir apparaître.

Si vous décidez de conserver toutes les colonnes, un défilement horizontal sera disponible sur les écrans de petite taille afin de permettre l’accès à l’ensemble des informations.

Listes de résultats

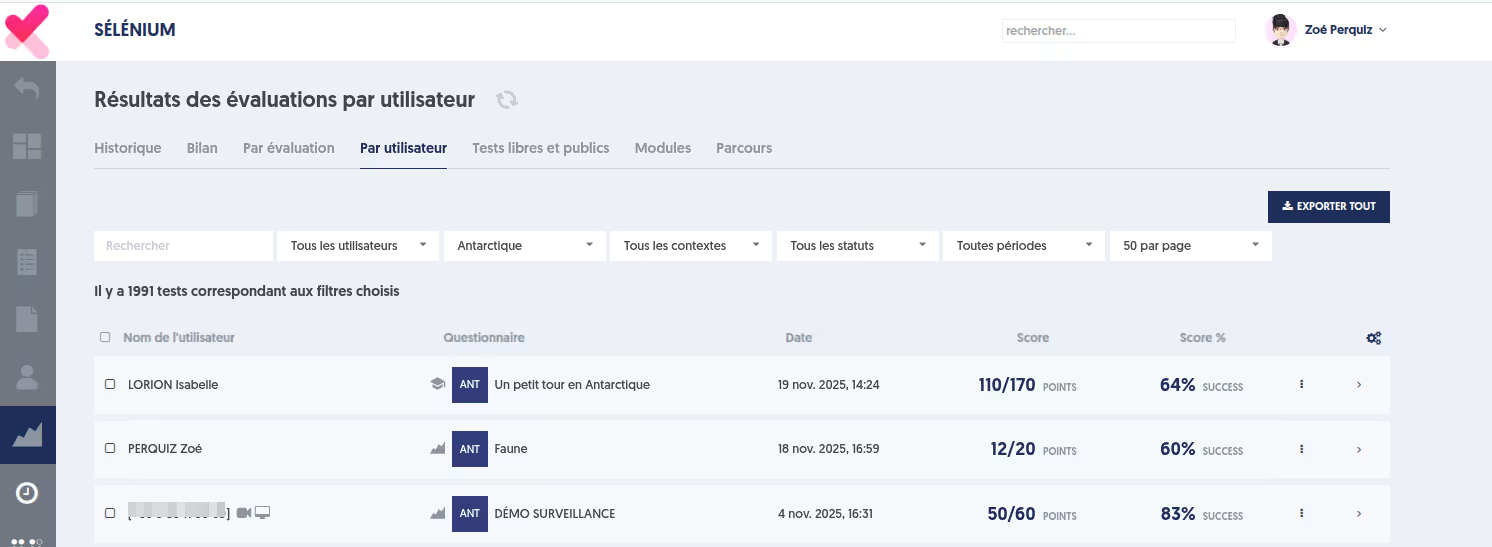

Par utilisateur ou Tests libres et publics

AVANT

APRÈS

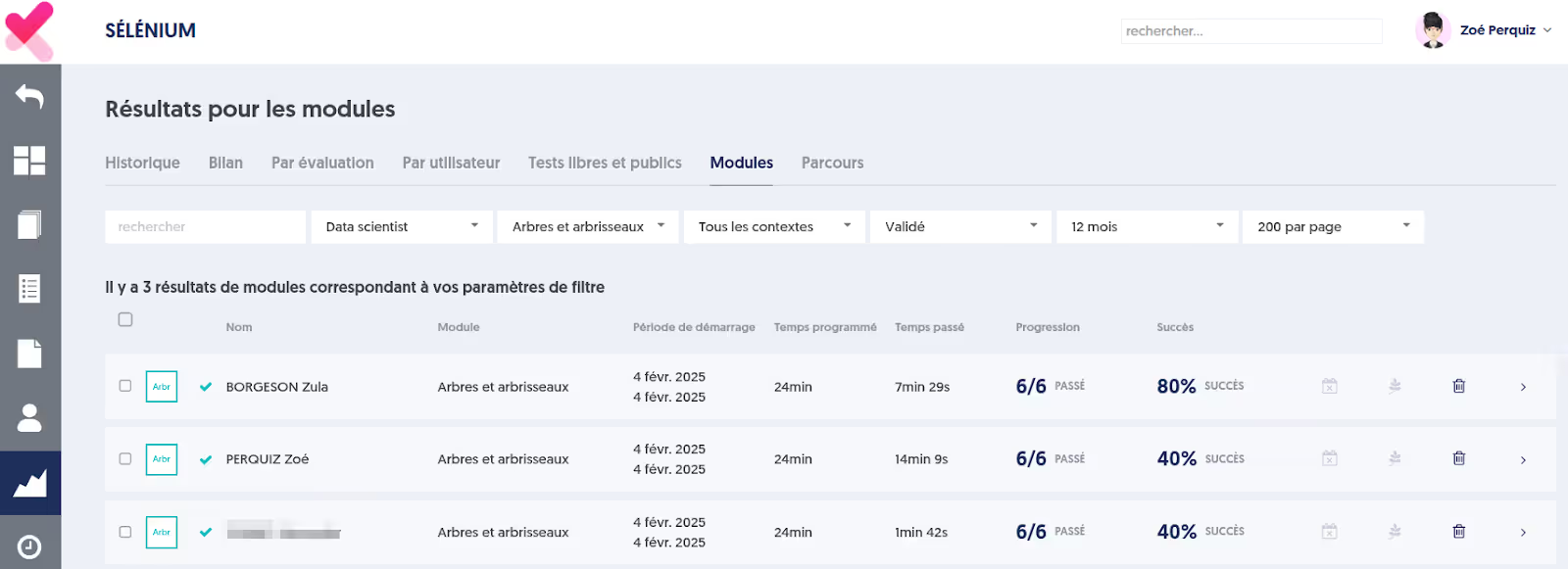

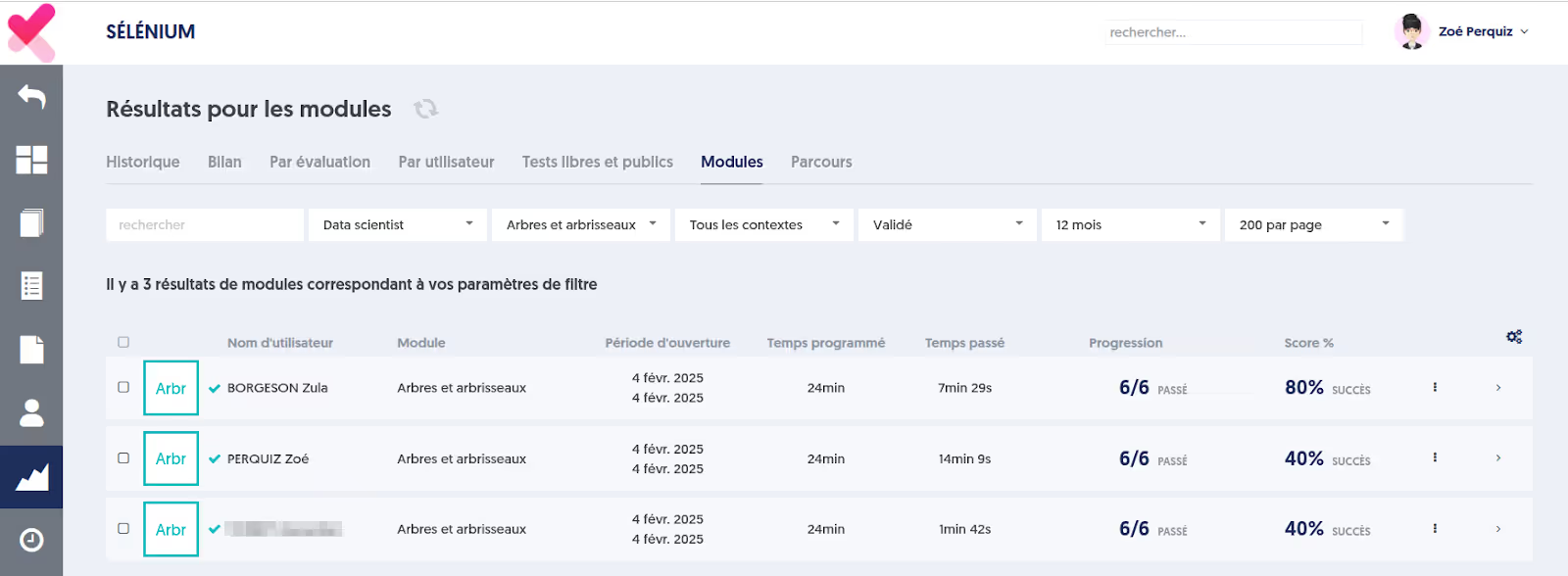

Modules

AVANT

APRÈS

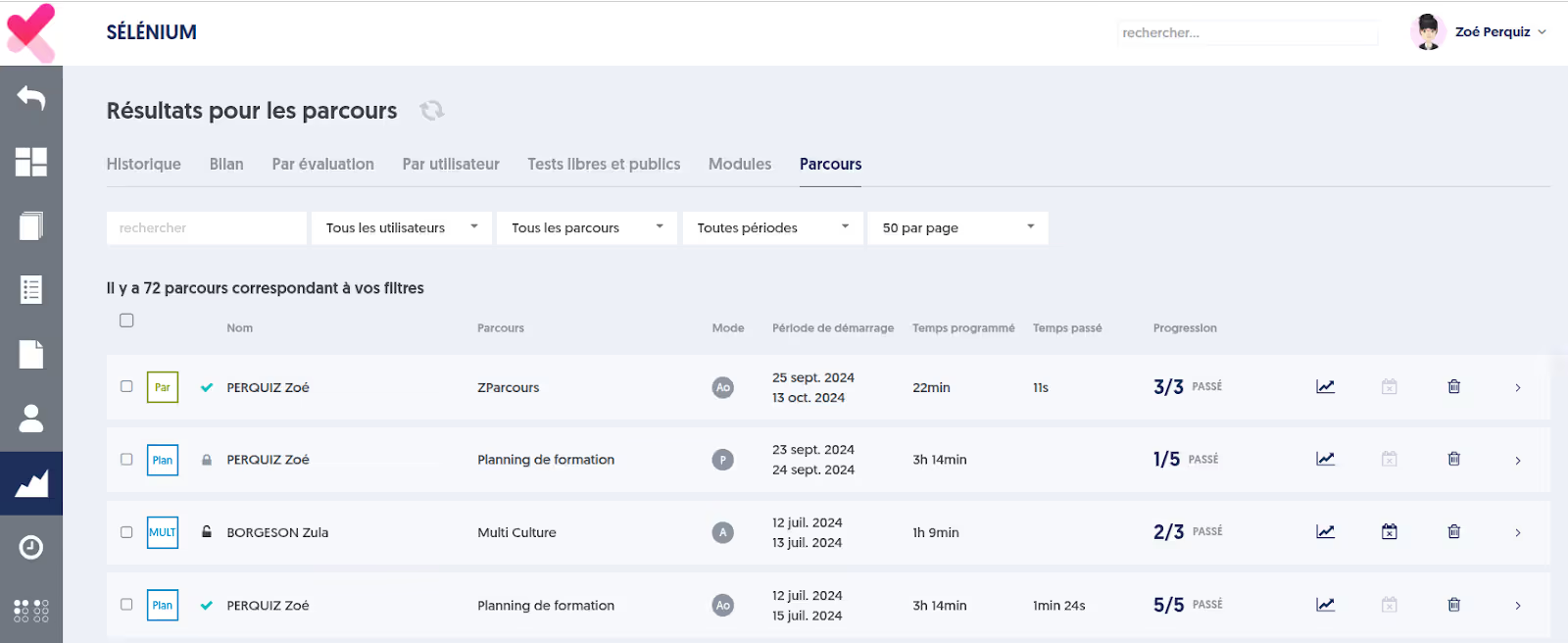

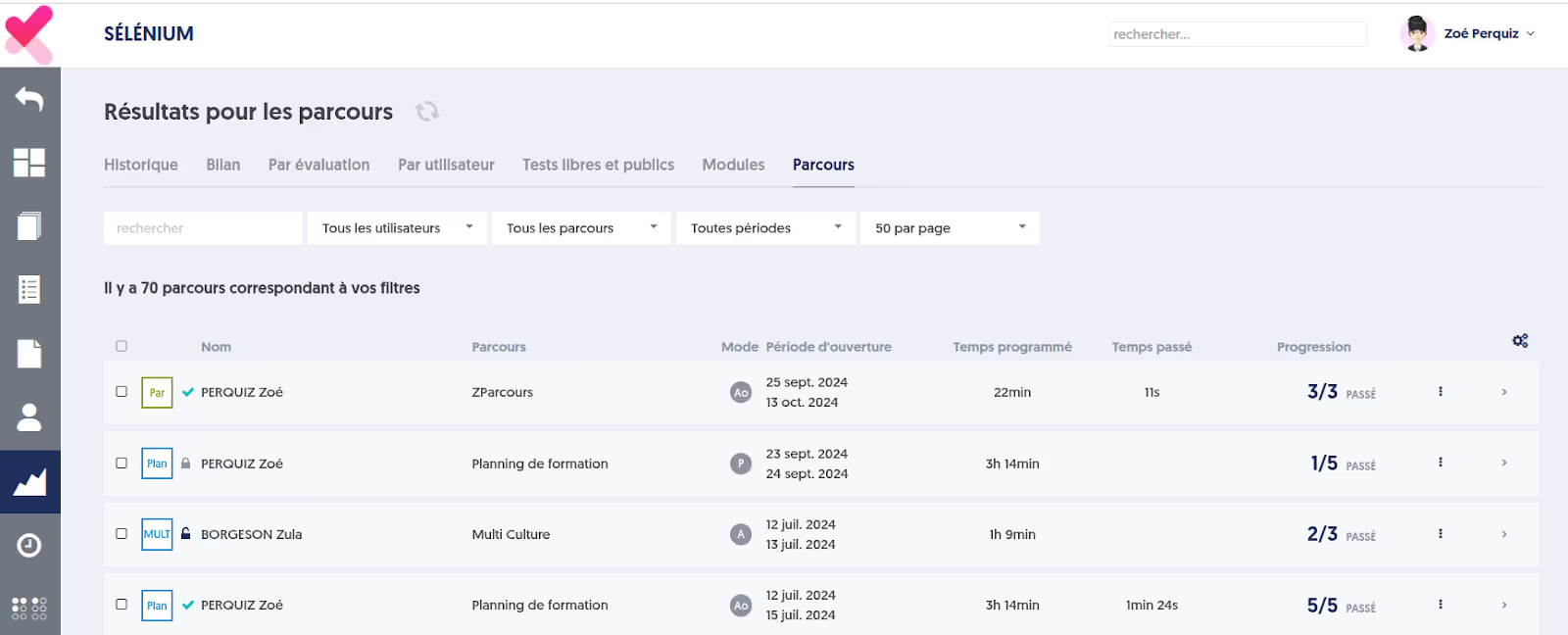

Parcours

AVANT

APRÈS

Qualité d’une base et des questionnaires

Les analyses portant sur la qualité d’une base de questions ont été enrichies de manière très importante.

Rappelons d’abord en quoi consiste ce type d'analyse.

Analyses de la qualité des questions et fiabilité des tests

Chaque fois qu’une personne répond à une question, on obtient de l’information quant à la connaissance de la personne (et c’est en général ce qui nous intéresse le plus), mais on obtient aussi de l’information relativement à la question elle-même. Par exemple, est-ce une question facile (réussie par beaucoup de participants) ou bien difficile (réussie par peu de participants) ?

Mais il y a beaucoup d’autres analyses possibles, et très importantes.

Parlons de la corrélation. D’une manière générale, si l’on a une base de questions portant sur un sujet particulier, disons par exemple le RGPD, on s’attend à ce que “plus une personne connaît bien le RGPD, plus il répond correctement à chacune des questions”. Cela semble très simple et presque évident. Si je considère une question spécifique de ma base, disons la question #23, je m’attends à ce que “plus une personne a un bon score global, plus elle réussit aussi la question #23. Ce n’est pas systématique : il est possible qu’une personne d’un excellent niveau ait échoué à cette question. Mais c’est vrai en général, c'est-à-dire que la probabilité de succès à la question #23 est corrélée à la probabilité de succès au test global.

Si l’on dispose de suffisamment de données, cette corrélation peut se mesurer mathématiquement, et l’on pourra alors se demander, pour chacune des questions, si elle est bien corrélée à la base dans son ensemble. Cette corrélation est une bonne mesure de la qualité de la question, c'est-à-dire de la capacité de cette question de contribuer à la mesure de la connaissance sur cette thématique.

À partir de ce type d’analyse, il est possible de calculer le coefficient “Alpha de Cronbach”, qui est une généralisation du coefficient de Kuder-Richardson, appelé KR-20. On peut dire schématiquement que c’est une mesure d’ensemble de la qualité de la base de questions, autrement dit : plus ce coefficient est élevé, plus les tests utilisant ces questions pourront être fiables. En général, on vise un KR20 supérieur à 70%, et il est courant de parvenir à des valeurs supérieures à 90%.

Une valeur de KR20 inférieure à 70% n’est pas satisfaisante, c’est-à-dire que vos tests ne seront pas d’une fiabilité suffisante. Que peut-on y faire ? C’est assez facile en fait : il suffit de rechercher les questions qui ont une faible corrélation, et soit de les améliorer, soit encore plus simplement de les supprimer.

Les questions qui ont une corrélation négative avec la base dans son ensemble sont vraiment à corriger ou supprimer : ce sont des questions telles que “plus une personne maîtrise bien la connaissance sur cette thématique, moins elle trouve la bonne réponse à cette question”. Autant dire que la question est sans doute soit très mal formulée, soit tout simplement erronée (la bonne réponse n’est pas celle indiquée, les experts connaissent la bonne réponse, donc ils échouent).

À partir de la valeur du KR20, il est possible de déterminer l’erreur standard, c’est-à-dire la marge d’erreur associée aux résultats obtenus à un test utilisant ces questions.

Même avec d’excellentes questions, il est courant que l’erreur standard soit de l’ordre de 5 %, soit environ ±1 point sur une note de 20. Cet indicateur est essentiel : si votre erreur standard est de 15 %, par exemple, un score de 15/20 doit en réalité être interprété comme se situant entre 12/20 et 18/20. Le niveau d’imprécision devient alors préoccupant.

Notons que l’erreur standard dépend à la fois du KR20 et du nombre de questions du test. Plus le test comporte de questions, plus l’erreur standard diminue.

C’est pourquoi cet indicateur est surtout pertinent au niveau d’un questionnaire donné, et non à l’échelle d’une base complète de questions.

Retenez surtout ceci : les analyses statistiques de qualité font intervenir des calculs un peu complexes, mais vous n’avez pas à vous en préoccuper, il vous suffit de regarder les résultats et les recommandations qui vous sont présentés.

Découvrez également notre article dédié à la fiabilité des évaluations.

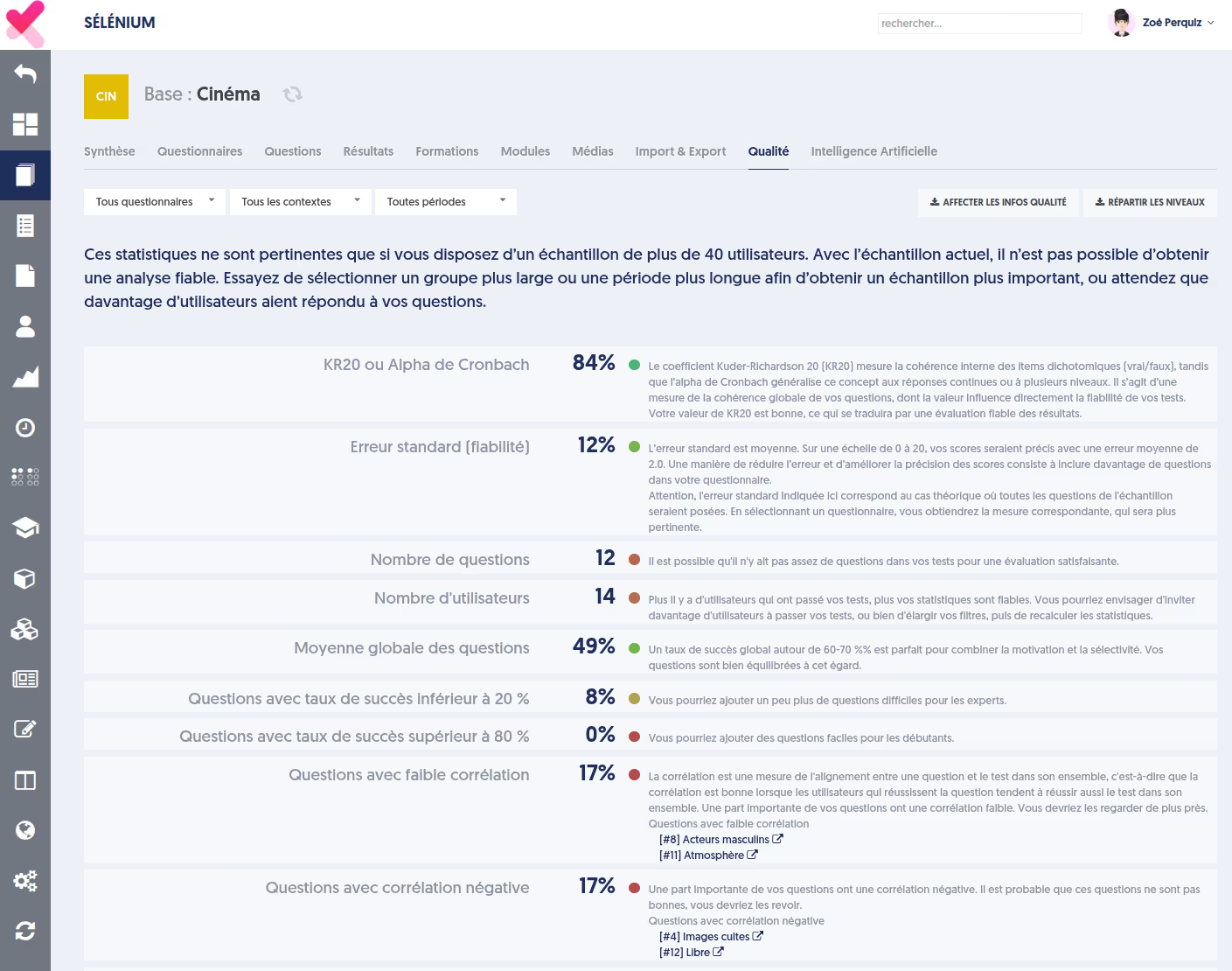

Les indicateurs principaux

Ces analyses sont offertes par la plateforme Experquiz depuis des années, mais elles ont été sensiblement améliorées, et rendues plus performantes, dans cette version.

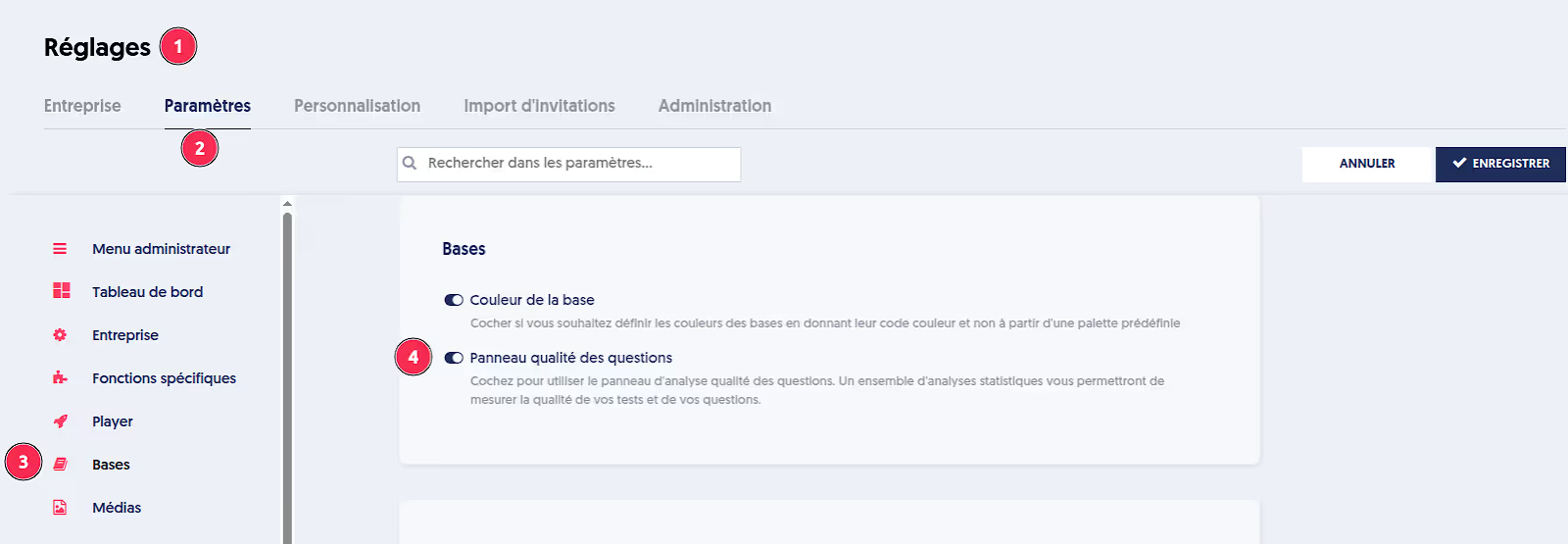

Pour accéder aux analyses qualité, il vous faut en premier lieu activer la fonctionnalité dans les réglages de votre entreprise (Onglet “Paramètres”, section “Bases”).

Au niveau de chacune de vos bases de questions, vous disposez alors d’un onglet “Qualité”, qui se présente comme ceci:

Vous disposez des filtres suivants :

- Soit tous les questionnaires, soit l’un seulement des questionnaires de la base.

- Vous pouvez choisir un contexte de test particulier, par exemple si vous pensez que les résultats relevant d’une évaluation sont plus pertinents que les résultats en tests libres.

- Vous pouvez sélectionner une période spécifique, pour ne considérer que les résultats de cet intervalle.

La page présente ensuite un tableau d’indicateurs, et pour chacun des indicateurs, une pastille de couleur indiquant dans quelle mesure la valeur est statisfaisante, et un commentaire extensif accompagné de recommandations.

Si votre échantillon (les tests correspondant à vos filtres) porte sur moins de 40 utilisateurs, un avertissement est présenté en haut de page, vous mettant en garde sur la fiabilité des analyses. Ce type d'analyse n’est vraiment pertinent que si plus de 40 utilisateurs ont répondu à vos questions.

Les indicateurs sont les suivants :

- Alpha de Cronbach / KR20 : voir l’explication au chapitre précédent.

- Erreur standard : Voir l’explication au chapitre précédent. Rappelons qu’elle n’a vraiment de sens que pour un questionnaire donné.

- Nombre de questions : pour des scores fiables, il faut que vos tests incluent un nombre suffisant de questions, si possible au moins 30 questions. Sur des tests de moins de 20 questions, les aléas sont plus importants, et l’erreur standard sera plus importante.

- Nombre d’utilisateurs : comme énoncé en préambule, ces analyses requièrent au moins 40 utilisateurs.

- Moyenne globale des questions : on considère qu’un taux de succès moyen autour de 60 à 70% est idéal pour combiner motivation (le participant est motivé par ses succès) et sélectivité (tous les participants ne réussissent pas toutes les questions). Mais cet indicateur n’a pas une importance critique.

- Questions avec taux de succès inférieur à 20 %

- Questions avec taux de succès supérieur à 80 %

- Questions avec faible corrélation : voir plus haut, l’explication relative à la notion de corrélation. Une question de faible corrélation est une question telle que “les participants les plus experts ne répondent pas mieux à cette question que les participants les plus faibles”. La question n’est peut-être pas erronée, mais elle ne semble pas mesurer la même connaissance que les autres questions.

- Questions avec corrélation négative : comme vu plus haut, les questions à corrélation négative sont vraiment un souci, il faut absolument s’en préoccuper car elles dégradent la qualité de vos tests.

- Questions avec faible Q1-Q4 : on fait appel ici à une notion qui ressemble à la corrélation, mais se calcule d’une manière un peu différente.

Pour ces trois derniers indicateurs, le tableau présente la liste complète des questions concernées, avec un lien permettant de modifier la question dans un nouvel onglet.

Les graphiques

La partie suivante de la page présente 4 graphiques :

- La distribution du taux de succès des questions : sur l'axe horizontal, toutes les questions sont rangées du taux de succès le plus faible (les plus difficiles) à gauche, jusqu'au taux de succès le plus fort (les plus faciles) à droite. Sur l'axe vertical, vous pouvez lire le taux de succès des questions. Idéalement, c’est une courbe qui pourrait être une droite conduisant de 0% à gauche jusqu’à 100% à droite. Il n’y a pas véritablement de mauvaise configuration, mais si par exemple la courbe atteint les 100% dès le milieu, c’est-à-dire que la moitié de vos questions ont un taux de succès de 100%, cela signifie sans doutes qu’il manque des questions plus difficiles, car toutes ces questions que tout le monde réussit n’apporte pas tellement à vos scores.

- La distribution des taux de succès des participants : sur l'axe horizontal, tous les participants sont rangés du taux de succès le plus faible (les moins experts) à gauche, jusqu'au taux de succès le plus élevé (les plus experts) à droite. Sur l'axe vertical, vous pouvez lire le taux de succès des participants pour chaque décile. Le point à X = 50% indique la médiane des taux de succès des participants.

- La distribution des taux de corrélation des questions : sur l'axe horizontal, toutes les questions sont rangées de la corrélation la plus faible à la meilleure. Les questions qui ont un taux de corrélation faible (inférieur à 20%) ne contribuent pas beaucoup à la construction des scores. Les questions qui ont un taux de corrélation négatif dégradent la fiabilité de vos tests. Sur l’image ci-dessous, on voit que quelques questions ont une corrélation négative.

- La distribution de la différence des scores des 1er et 4ème quartiles : les utilisateurs sont répartis en quartiles, c'est-à-dire que les 25% les meilleurs (sur l'ensemble du test) constituent le premier quartile, et les 25% les moins bons constituent le 4ème quartile. Pour chacune des questions, on peut alors calculer le score moyen des participants du premier quartile, et le score moyen des participants du 4ème quartile. On calcule ensuite la différence Qt1 - Qt4. Les questions sont rangées par différence croissante. L'écart des quartiles est une mesure de cohérence des questions, de même nature que le coefficient de corrélation.

La matrice de corrélation et les clusters de questions

En bas de la page, vous trouverez la matrice de corrélation complète, qui présente, sous la forme de petits carrés colorés, la corrélation entre chaque couple de questions de la base.

Les cases de couleur verte, plus ou moins intense, représentent un couple de questions qui ont une corrélation positive. Cela signifie que si les personnes réussissent la première question, il est probable qu‘ils réussissent également la seconde. Plus la couleur verte est intense, plus la corrélation est forte.

Réciproquement, les cases de couleur rouge représentent un couple de question qui ont une corrélation négative : lorsque l’on réussit à la première question, alors il est probable que l’on échoue à la seconde.

Sur la base de ces corrélations, on peut construire ensuite des groupes de questions qui sont corrélées entre elles, des clusters. Lorsqu’une personne réussit l’une des questions du clusters, il est probable (très probable ou un peu probable), qu’elle réussisse également les autres questions du cluster.

Cela ne doit pas amener à penser que les questions du cluster sont égales et que l’une seulement pourrait suffire. D’abord la corrélation ne prouve pas que la connaissance mesurée est la même, et de plus il est toujours bon d’aborder une notion sous différents angles, avec des questions variées.

Les boutons d’action

En haut de cette page qualité, vous disposez de deux boutons d’action. Ils ne sont actifs que si l’échantillon inclut suffisamment de participants pour permettre des analyses satisfaisantes.

- le bouton AFFECTER LES INFOS QUALITÉ : ce bouton attache les informations calculées ici à chacune des questions de la base. Ces informations peuvent ensuite être visualisées dans la liste des questions de la base, en choisissant la “vue qualité”. Ainsi vous disposerez, pour chaque question, de son taux de succès moyen, sa corrélation à l’ensemble de la base, l’écart des premiers et quatrième quartile.

- le bouton RÉPARTIR LES NIVEAUX : ce bouton permet de redéfinir le niveau de difficulté de chacune des questions de la base. Les questions sont rangées de la plus facile (plus haut taux de succès) à la plus difficile (plus faible taux de succès), les 20% de questions les plus faciles reçoivent la valeur 1 pour leur niveau. Les 20% suivants auront la valeur 2. Et ainsi de suite jusqu’aux 20% les plus difficiles, qui auront la valeur 5.

C’est un outil très utile pour affecter un niveau de difficulté fiable. En effet, les contributeurs ne peuvent pas déterminer avec certitude si une question est de difficulté 2 ou bien 3. Avec cette fonctionnalité, vous avez une mesure de la difficulté basée sur les réponses de vos utilisateurs.

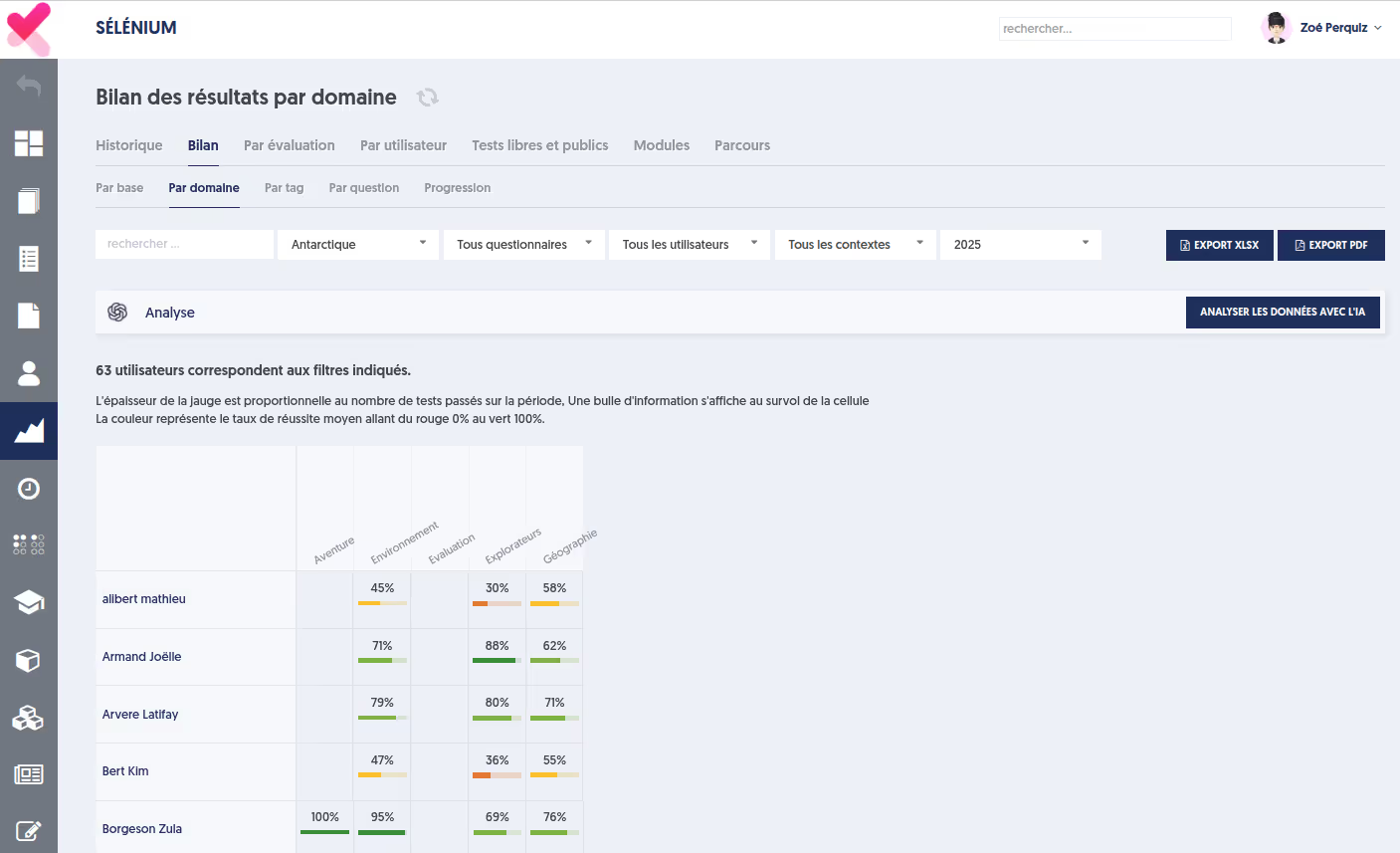

Export des bilans

Experquiz propose de multiples analyses des scores, sur différents axes et avec de nombreuses possibilités de filtres.

Ces analyses sont disponibles sur l’onglet “Bilans” de la page “Résultats”, comme illustré ci-dessous :

Vous disposez de 5 sous-onglets : par base, par domaine, par tag, par question, et progression.

Nous nous intéressons ici aux 3 onglets du milieu : par domaine, par tag et par question.

Le premier onglet vous apporte une analyse des scores par domaine obtenus par chaque utilisateur. Vous pouvez filtrer :

- Une base spécifique

- Un questionnaire spécifique, ou bien tous les questionnaires

- Un groupe d’utilisateurs ou bien tous les utilisateurs

- Un contexte de passage spécifique : évaluation, certification, test libre

- Et enfin une période sur laquelle les passages de tests sont considérés.

Une fois tous les filtres réglés selon vos besoins, l’onglet “par domaine” présente, pour chaque personne incluse dans le périmètre, le score obtenu sur chacun des domaines. C'est-à-dire la moyenne des scores obtenus sur toutes les questions qui appartiennent à ce domaine. Notez que si la personne a effectué plusieurs tests sur la période, les valeurs affichées correspondent à la moyenne sur l’ensemble des tests.

D’une manière très semblable, les onglets suivants, “par tag” et “par question”, présentent les résultats consolidés de chaque utilisateur, pour chaque tag et pour chaque question.

Notez que si l’utilisateur qui est connecté et qui consulte ces analyses n’a accès qu’à un périmètre réduit d’utilisateur (que ce soit via la notion de groupe ou bien via l’organigramme de l’entreprise), alors ces pages sont naturellement filtrées sur le périmètre autorisé.

Par ailleurs, ces pages offrent la possibilité d’analyses réalisées par l’Intelligence Artificielle. Mais c’est un autre sujet !

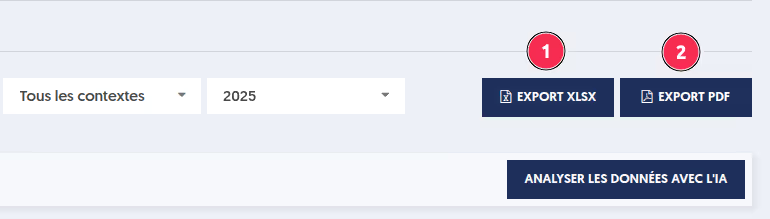

La fonctionnalité nouvelle permet d’exporter ces analyses, soit dans un fichier Pdf, soit dans un fichier Excel.

Lorsque vous cliquez l’un des boutons, un panneau s’ouvre sur la droite, vous permettant d’ajuster le contenu de votre fichier :

- Inclure ou non les analyses par domaine, par tag et par question.

- Inclure la totalité des utilisateurs ou bien uniquement les utilisateurs pour lesquels il existe des résultats.

Comme pour tous les exports de fichiers qui peuvent être importants, il y a deux possibilités, en fonction du volume de données :

- Si vos données incluent moins de 200 utilisateurs, l’export sera synchrone, c’est-à-dire que vous pourrez attendre que le fichier soit créé, et il sera affiché immédiatement.

- Si vos données sont plus volumineuses, l’export sera différé, c'est-à-dire qu’il sera réalisé pendant que vous pouvez continuer à travailler. Lorsque le fichier sera prêt, vous recevrez un email d’information.

Dans un cas comme dans l’autre, vous pouvez obtenir le fichier sur la page “Réglages”, onglet “Administration”, sous-onglet “Travaux différés”.

Export des questionnaires dynamiques

Menu évaluations

Deux nouvelles actions de gestion sont possibles au niveau de l’évaluation :

- Export de la copie vierge du questionnaire dans un fichier docx.

- Établir le corrigé de l’évaluation.

Ces deux actions sont nouvelles dans le cadre des questionnaires à tirage aléatoire puisque les questions ne sont connues qu’au moment du lancement du questionnaire.

Elles permettent ainsi :

- d’accéder immédiatement à une version vierge du questionnaire qui peut être accessible avant le démarrage de l’évaluation.

- Et, après l’invitation, d’obtenir le corrigé exact, correspondant au tirage réel des questions présenté au participant.

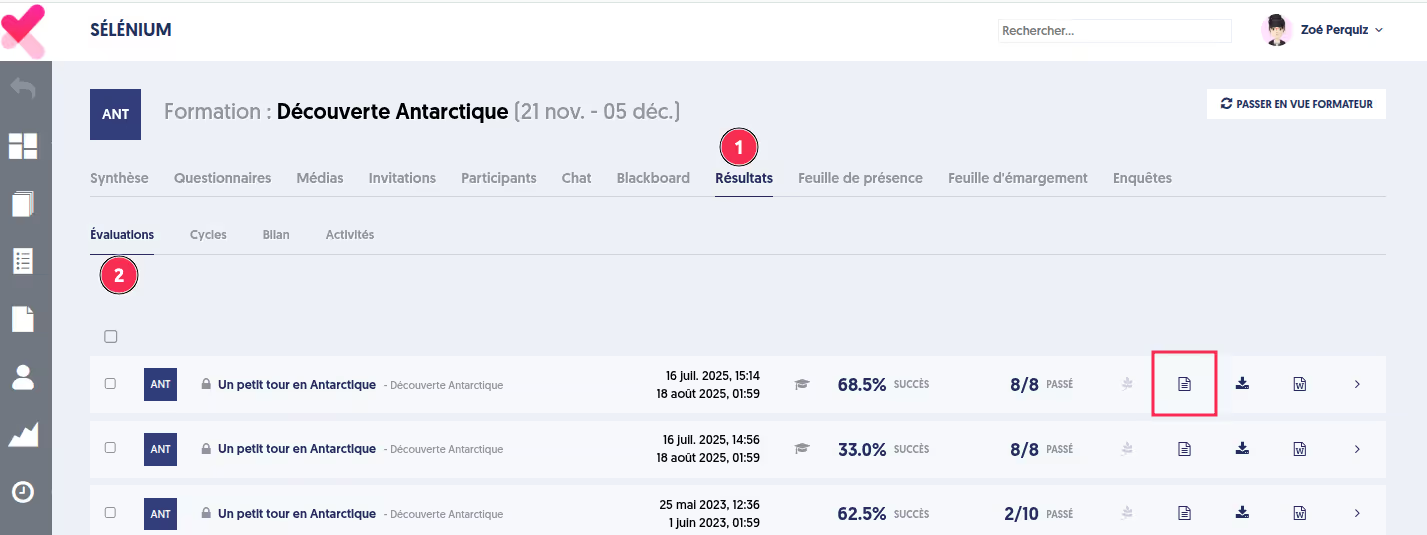

Menu Formation

Dans le menu formation, les résultats des évaluations passées durant la session de formation sont accessibles dans l’onglet “Résultats”, sous-onglet “Évaluations”.

La fonctionnalité d’export du questionnaire corrigé a été également ajoutée sur cette page.

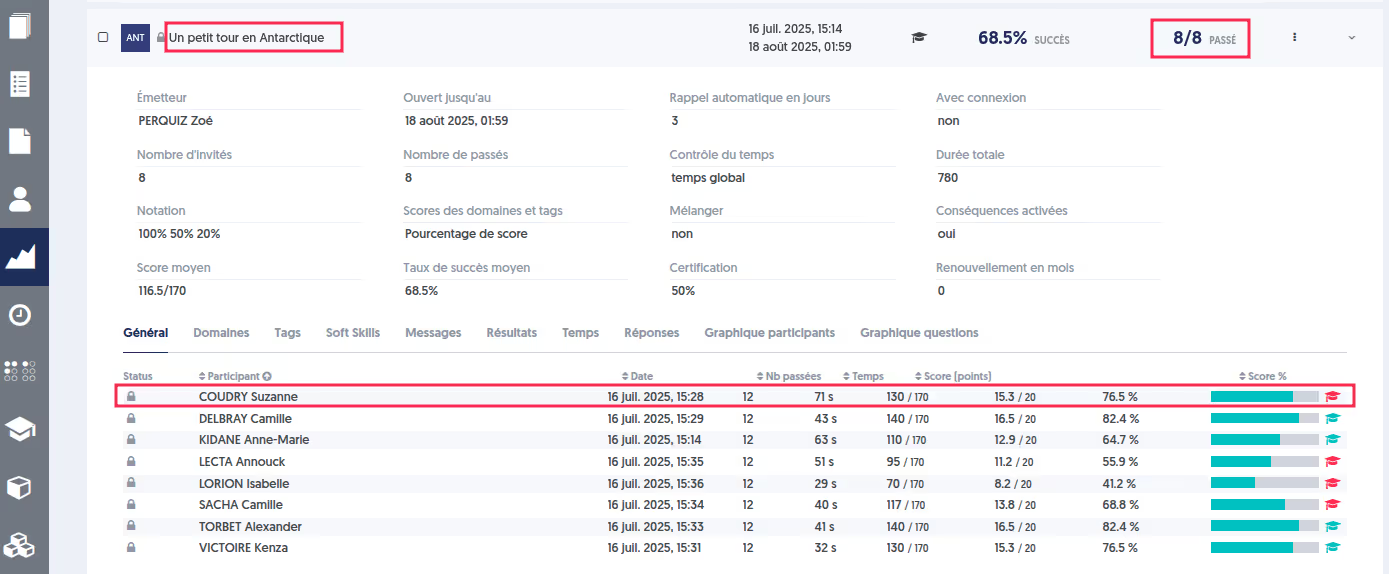

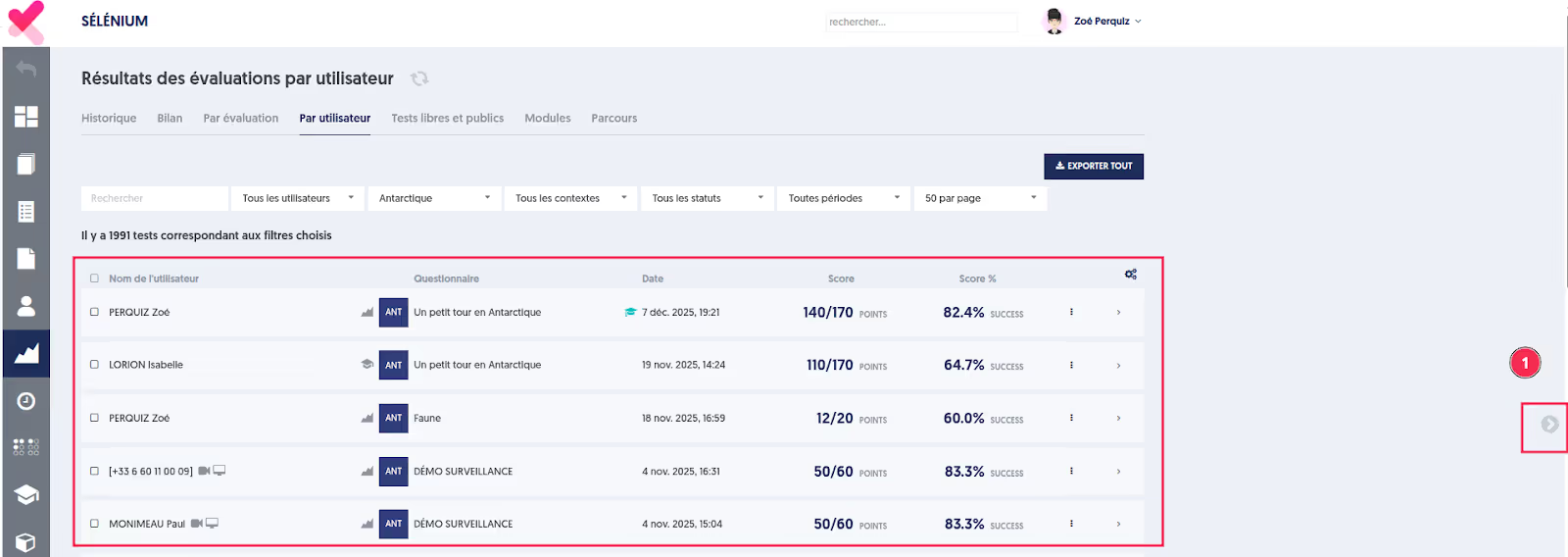

Suppression d’un test

Une évaluation correspond à une invitation à passer un questionnaire, adressée à plusieurs personnes. Lorsqu’une évaluation est terminée, une synthèse des résultats est présentée : statistiques sur les réponses des participants, temps de réponse, erreurs les plus fréquentes, …

La page regroupant l’ensemble des évaluations est accessible via le menu “Résultats/Évaluations”.

Les tests individuels de chaque participant sont quant à eux consultables dans le menu “Résultats/Par utilisateur”.

Jusqu’à présent, il n’était pas possible de supprimer le test d’un participant ayant terminé . Cette fonctionnalité vient d’être ajoutée.

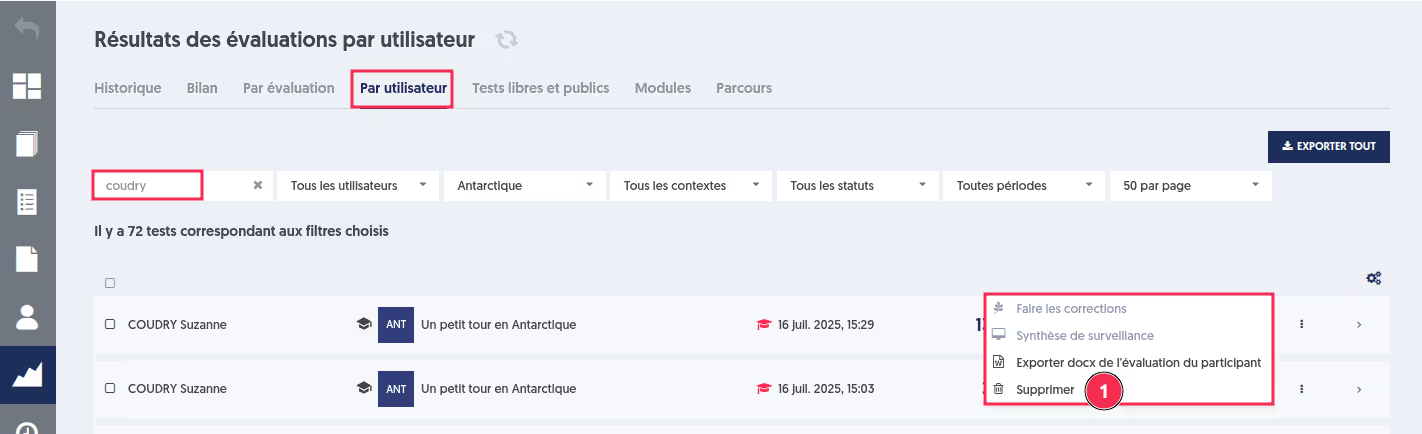

La suppression d’un test individuel inclus dans une évaluation se réalise désormais depuis la page “Résultats/Par utilisateur”.

Par exemple, prenons l’évaluation sur le questionnaire “Un petit tour en Antarctique” passée par 8 utilisateurs et supprimons le test de Suzanne Coudry.

Supprimons le test dans la page “Résultats/Par utilisateur”.

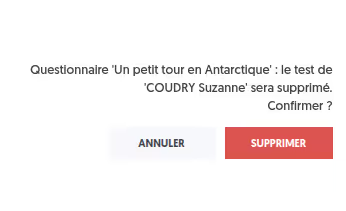

Une demande de confirmation apparaît alors afin de valider la suppression.

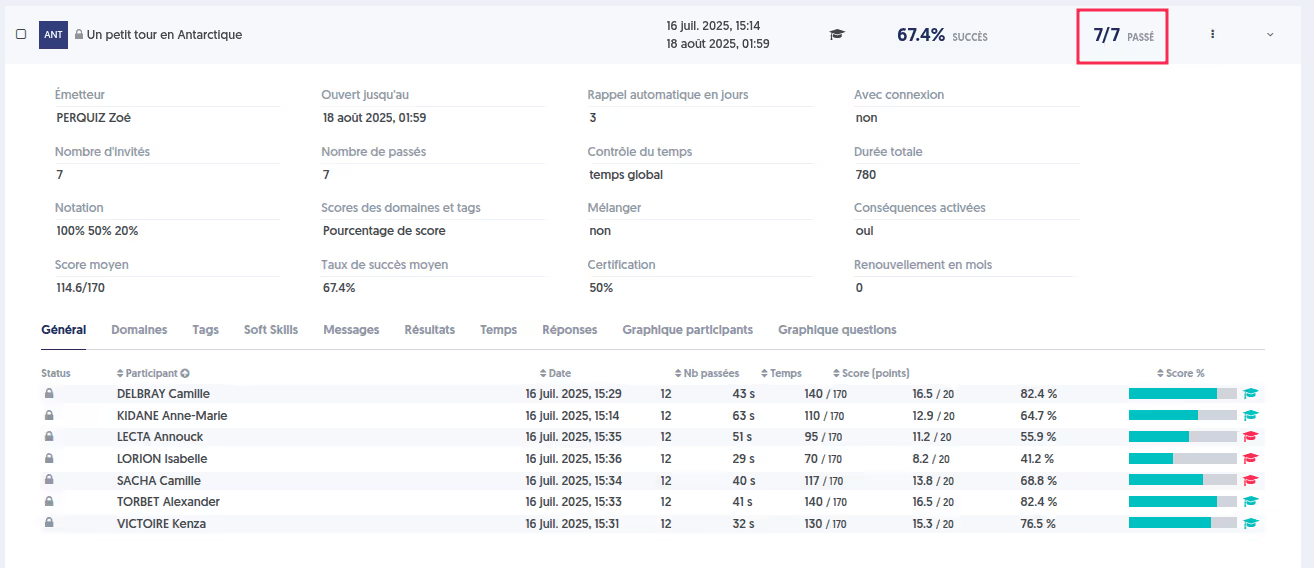

L’évaluation a été mise à jour.

Cette possibilité n’est pas disponible pour les évaluations de module ou de parcours. En effet, un module est constitué d’une suite d’étapes, et une évaluation peut valider une étape permettant d’accéder aux suivantes. Supprimer un test déjà validé perturberait fortement le déroulement du module.

Diplôme envoyé depuis la page de score

Lors de l’envoi d’une invitation à une évaluation, il est possible de paramétrer l’évaluation comme une certification.

Dans ce cas, un diplôme peut être associé et rendu disponible sur la page de score du participant.

Il est désormais également possible de spécifier une adresse e-mail dédiée à laquelle envoyer ce diplôme, saisie directement au moment de l’envoi de l’invitation.

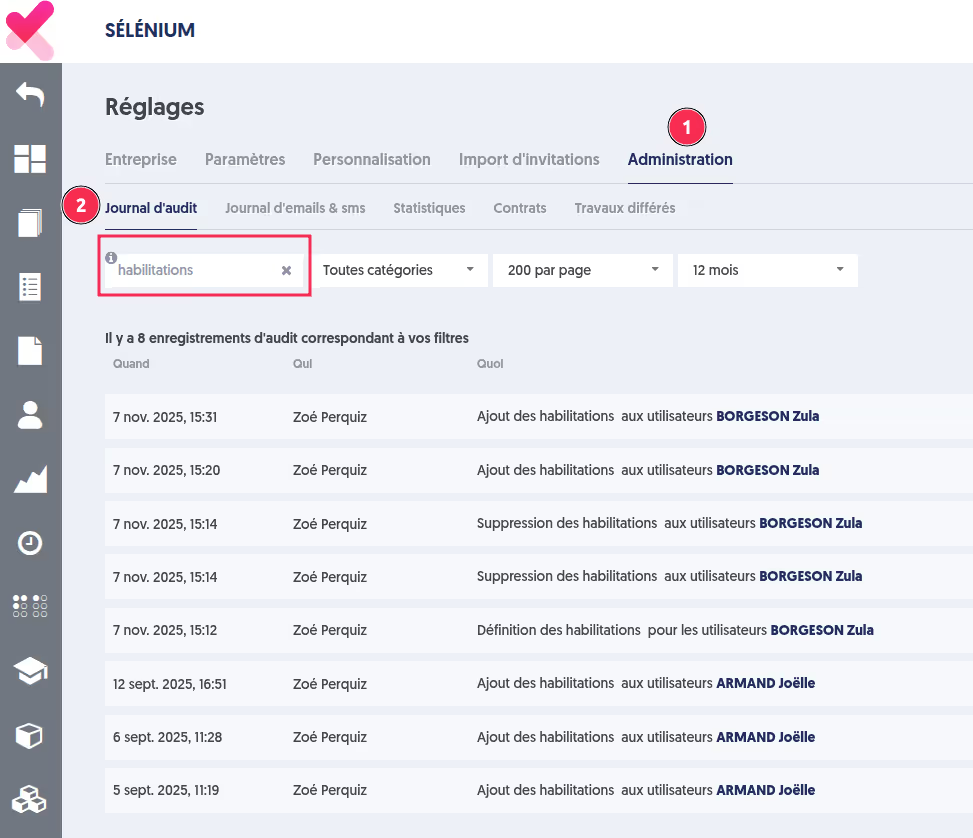

Recherche dans le journal d’audit

Le journal d’audit est accessible depuis le menu Réglage/Administration/Journal d’audit. Il permet de suivre l’ensemble des activités sur la plateforme, et leur déroulement.

Jusqu’à présent, il était uniquement possible de filtrer les entrées par catégorie.

Il est dorénavant possible d’effectuer un filtre par mot-clé, offrant une recherche plus précise et plus rapide au sein du journal.

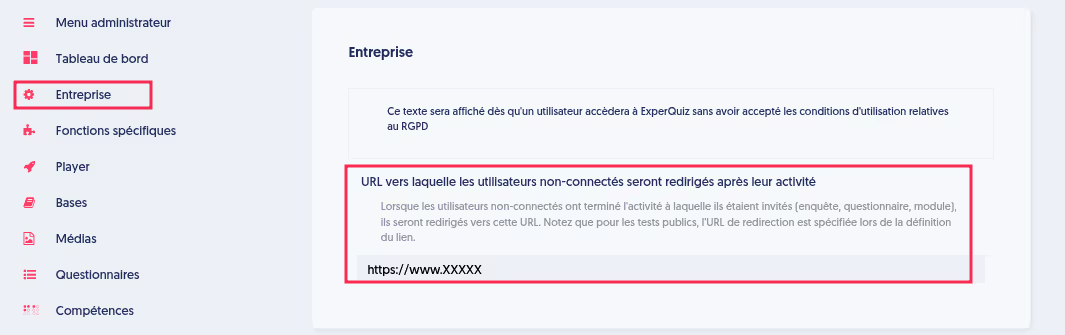

Page neutre

Vous pouvez partager une ressource, questionnaire ou module, en mode public.

Lorsque l’activité est terminée, le participant peut être redirigé :

1. Vers un lien spécifique au niveau du lien public.

2. Vers une url par défaut définie dans les paramètres de l’entreprise.

Si aucun lien n’a été spécifié, alors le participant revient vers une page neutre avec le logo Experquiz ou le logo de l’entreprise en marque blanche.

Vue plein écran

Si vous disposez d’un grand écran, vous pouvez profiter d’un affichage en plein écran en cliquant sur la petite flèche située à droite.

Support individualisé

Savez-vous que vous pouvez obtenir du support personnalisé ?

Que ce soit pour une question précise ou pour bénéficier d’un accompagnement gratuit d’une heure sur votre projet, il vous suffit de cliquer sur le bouton « Besoin de support ».

Connaissez-vous nos formations ?

Nous proposons plusieurs niveaux de formation pour vous permettre de maîtriser l'ensemble des fonctionnalités de la solution Experquiz.

Rendez-vous sur notre page dédiée pour en savoir plus !

La documentation Experquiz

Retrouvez toutes les informations pour utiliser les différentes fonctionnalités d’Experquiz dans notre espace documentaire librement accessible à l’adresse suivante : https://doc.experquiz.com/

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.png)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)